PANORAMA DE L’ÉVOLUTION DES TECHNOLOGIES DANS LES RÉSEAUX DE TÉLÉCOMMUNICATION

LES TECHNOLOGIES TRADITIONNELLES CÈDENT PEU À PEU LA PLACE AUX TECHNOLOGIES LIÉES AU LOGICIEL.

Article élu coup de cœur ❤️

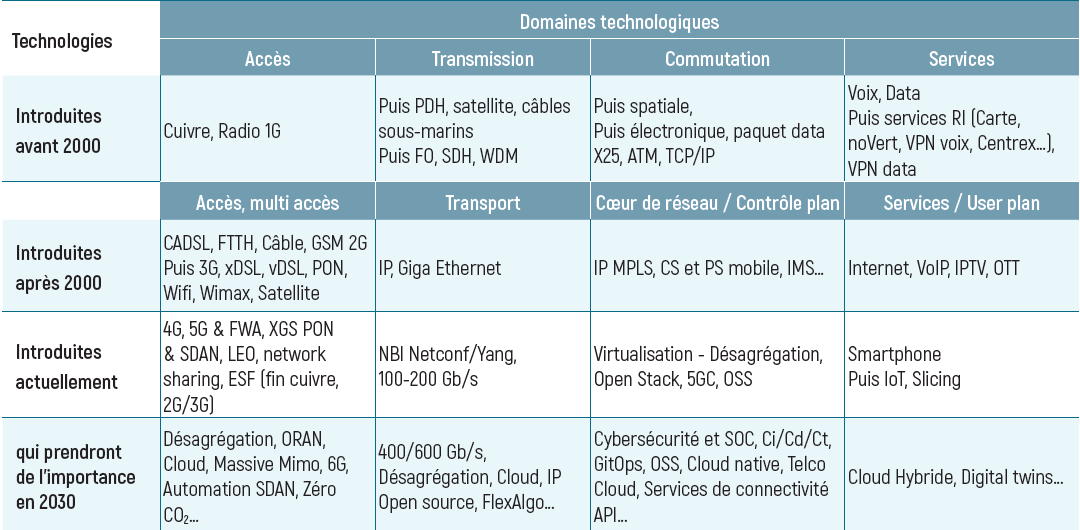

Quelles sont les technologies les plus importantes des réseaux de télécommunication, en termes de potentialités, d’utilisation actuelle et de contraintes d’héritage (legacy) ? Pour y répondre (voir tableau ci-dessous), il est nécessaire de compléter le point de vue habituel de performance (débit, latence, disponibilité…) par d’autres aspects qui deviennent plus importants : l’apport du logiciel, les besoins d’agilité et d’automatisation de l’exploitation

Les principales Technologies aujourd’hui

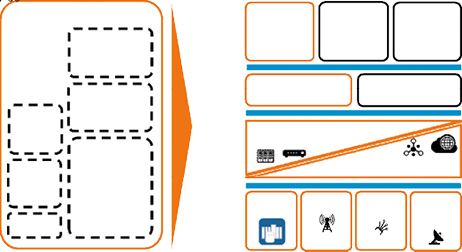

Les réseaux des Telco actuellement constitués d’équipements intégrés verticalement (hardware, logiciel) évoluent vers une structure désagrégée en couches (infrastructure commune, logiciel) interfacées par des APIs. De nouveaux acteurs apparaissent comme les TowerCo, FiberCo ou Hyperscaler. Ce phénomène de structuration désagrégée en couches (delayering) va amener à passer d’une structure de domaine « accès / transport / contrôle / service » à une structure « infrastructure / cloud / API & connectivité / service ».

Les Telco se transforment en data-software based Telco avec l’utilisation de l’AI / ML (Artificial Intelligence / Machine Learning).

La structuration désagrégée en couches des réseaux.

Les principales technologies du siècle dernier sont toujours utilisées aujourd’hui

Avant 2000, les besoins principaux de communication étaient la voix avec le RTC (Réseau Téléphonique Commuté) et les échanges de données en entreprise avec les liaisons louées et les réseaux de données. Les technologies sont catégorisées en transmission et commutation.

En transmission, l’utilisation de la fibre optique et le passage de l’analogique au numérique permet de régénérer et de préserver les signaux une fois numérisés. La numérisation du RTC se fait dans les années 70 en France, en numérisant et multiplexant la voix (MIC Modulation par impulsion codées). La transmission se fait d’abord en plésiochrone (PDH - Plesiochronous Digital Hierarchy) avec des équipements au même débit non synchronisés jusqu’à 140 Mbit/s puis en synchrone (SDH - Synchronous Digital Hierarchy) jusqu’à 10 Gbit/s. Le WDM (Wavelength Division Multiplexing) permet de transmettre plusieurs dizaines de couleurs et de multiplier par autant la capacité.

En commutation, il y a le passage du spatial (la connexion du signal analogique) vers du temporel (tout numérique). En 1990, le Réseau Intelligent (RI) est mis en œuvre pour le réseau fixe et mobile avec les fonctions Commutateur d’Accès aux services (CAS ) commandés par des points de commande de services (PCS) pour le contrôle de la communication, l’exploitation et les aspects commerciaux. La commutation pour les paquets de données se fait en X25, en ATM ou en TCP / IP.

Les années 2000 : un tournant majeur

L’époque est marquée par la mobilité et la croissance des données.

Les accès deviennent multiples (fixe, mobile, wifi…) et les services sont plus complexes (voix, internet, TV et mobile). Le Wimax est utilisé par exemple pour l’accès radio pour les entreprises. L’ADSL, le FTTH, le câble permettent l’augmentation notable du débit d’accès (autour du Mbit/s) alors que la 2G GSM puis la 3G UMTS permettent la mobilité de la voix / data (Mbits/s et plus avec la 3G+ HSDPA).

Tous les flux de services sont des données (VoIP, IPTV…) avec un transport unifié par l’IP et le Giga Ethernet au-dessus de la transmission.

Le cœur de réseau se complexifie avec le rajout des CS - Circuit Switch et PS - Packet Switch pour les mobiles et la possibilité de faciliter le contrôle du fixe ou du mobile avec l’IMS (IP Multimedia Service) qui permet de faire de la VoIP en résidentiel ou pour les entreprises.

Le principe du RI est généralisé avec les plateformes de services pour la VoIP ou l’IPTV. Les services OTT (Over The Top) internet sont partout (réseaux sociaux, achat en ligne, gaming…).

Aujourd’hui : un renouvellement du réseau qui donne une place importante au logiciel et au cloud

Les accès 2G / 3G ou cuivre commencent à être retirés en parallèle de l’introduction de la 4G et de la 5G (100 Mbit/s, 1 Gbit/s) et du déploiement du XGS-PON pour la fibre (10 Gbit/s). Il est nécessaire d’automatiser la gestion du réseau d’accès fibre avec des logiciels d’automatisation, dans un environnement multi opérateur (SDAN - Sofware Defined Access Network). Les flottes de satellites à orbite basse (LEO - Low Earth Orbit comme SpaceX, OneWeb…) permettent l’accès depuis les zones sans infrastructure terrestre.

Les interfaces 100, 200 Gbit/s sont les plus utilisées pour le transport et les besoins complexes nécessitent une exploitation agile via la commande des NBI (North Bound Interface) des équipements en langage Netconf / Yang. Cette commande est de plus en plus automatisée, par exemple pour la gestion du backhaul des réseaux mobile.

Les équipements de cœur de réseau sont systématiquement « désagrégés » (voir illustration ci-dessous), c’est à dire virtualisés (VNF - Virtual Network Function) sur une infrastructure cloud de type Open Stack ou VMware, sur des serveurs internes – Telco Cloud (e.g., cœur du réseau 5GC) ou du cloud public des Hyperscalers (par ex. les applications IT sur AWS, Azure, GCP…). L’IT du réseau (OSS - Operation Support Systems) devient prépondérant et s’oriente vers de l’Open source.

Scénario possible de transformation d’un Telco Brownfield (avec des équipements legacy).

Les services sont plus complexes avec la généralisation des smartphones, l’augmentation des besoins pour l’IoT (Internet of the Things) et l’utilisation du slicing pour les réseaux dédiés entreprise.

Les technologies majeures en 2030

La désagrégation actuelle du cœur de réseau va s’étendre à l’accès, d’abord pour les mobiles (ORAN - Open Radio Access Network avec la disponibilité de mécanismes d’accélération, la partie physique qui reste étant l’antenne massive mimo commandée à distance). La 6G, en attente des spécifications des besoins, n’est pas encore finalisée, mais embarquera dans tous les cas une augmentation du débit et des principes d’économie d’énergie. Par exemple, l’automatisation et de l’IA permettront de gérer finement la puissance d’émission dans les cellules. L’accès fixe, automatisé avec SDAN, devra toujours être privilégié du fait d’une consommation 100 fois moindre que l’accès mobile. Tous les équipements d’accès seront fabriqués sans produire de CO2.

La désagrégation du transport qui utilise des interfaces 400 / 600 Gbit/s est plus lente. La couche IP est de plus en plus mise en œuvre avec de l’Open source, avec des fonctions de routage FlexAlgo plus adaptées au slicing. Les mécanismes de sécurité deviennent de plus en plus importants.

L’intelligence du réseau (contrôle, services) évolue constamment grâce à l’agilité software, les approches Ci / Cd / Ct (Continuous integration / deployment / testing) et GitOps dans un environnement totalement cloud native sur une infrastructure Telco Cloud standardisée. L’OSS1 est temps réel et devient la partie la plus importante du réseau.

Les services de connectivités sont disponibles digitalement (via des API - Application Program Interface) pour les applications d’entreprises. Mais les aspects technologiques les plus importants sont ceux liés à la Cybersécurité avec une architecture no trust, une détection proactive des attaques par les SOC (Security Operation Center) et l’utilisation de l’IA. Les services seront mis en œuvre dans un environnement cloud hybride (cloud privé des Telco, cloud public Hyperscaler). L’utilisation de Digital Twins intégrant les services de connectivités devient indispensable pour une résilience optimale des entreprises.

Conclusion

Les réseaux évoluent d’un monde intégré verticalement à une structure désagrégée en couches. De nouveaux acteurs apparaissent (hyperscalers, ServiceCo, InfraCo…) dans ce contexte. L’infrastructure passive (antenne, traitement du signal, satellite, serveurs cloud, terminaux…) continue à utiliser les technologies traditionnelles complétées par de l’automatisation. En revanche, l’infrastructure active devient entièrement logicielle et automatisée de bout en bout en s’appuyant sur l’OSS.

Référence :

1 Orange and Huawei released the Future OSS White Paper on “Providing the agility to support digital operations transformation of hybrid networks | LinkedIn https://www.linkedin.com/pulse/orange-huawei-released-future-oss-whitepaper-providing-marc-bikok/

Roberto KUNG

graduated from École Polytechnique and Télécom Paris. At Orange, he has been Technology & Operations SVP and has been responsible for the Orange Expert program (the top 600 Orange experts on Network technologies and operations, Security, Data and AI, Software or Environment and services aspects).

Prior to that, he has been Head of Orange Core Networks R&D, Head of Lannion site, Head of network strategy, Head of Strategy & Planning for long-distance. He has also been active in R&D, on the IN Program, member of TINA-C and head of the WG on IN at ITU-T.